当然,AlphaGo只不过是一款游戏程序而已,即使你无法参透它复杂的思维过程倒也并不碍事。但对自动驾驶汽车而言,这种“不透明性”可能造成的后果是非常严重的。试想,一辆无人车犯错了,按正常的逻辑来说,肯定是得让工程师找到病根,进而对漏洞进行修复,确保它不会再犯同样的错误。目前有一种方法是借助模拟的形式,先展示给机器大脑一个特征,之后再提供另一个特征,以此类推,以便找出影响其决策的关键因素。

大家都是明眼人,这种方法不仅费时费力,而且不保证能够得到你想要的结果。

那怎么办呢?最近,车用AI芯片供应商英伟达联合卡内基·梅隆大学的研究人员,找到了一种能够让人工智能系统决策过程变得更透明的简单方法。英伟达汽车部门高级主管Danny Shapiro介绍称,“深度神经网络能够通过自主学习逐步提升驾驶经验,但这样的经验是无法通过手动编程提供的。即便如此,我们仍然有能力向大家解释为什么系统会做出这样或那样的决策”。

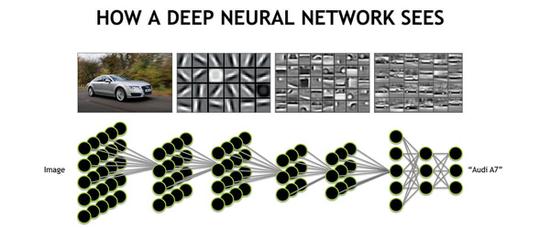

Shapiro表示,这个方法的关键在于它能够利用可视化地图将神经网络在看到图片后标记的重要特征进行定位。下面这几张图片是在汽车前置摄像头采集数据的基础上进行可视化加工而成的,而开发人员还只是在进行‘利用深度神经网络控制车辆转向以保证其在车道线内行驶’领域的研究。

不过话又说回来了,目前工程师其实对人工智能系统出现的bug仍然束手无策,而回到本源,深度神经网络并不是由人工代码架构而成的,所以其实这里可能用“bug”都不是很合适,整个系统中对最终决策最关键的其实是一系列的识别特征。尽管‘黑匣子’的透明性依然难破,但起码现在我们可以将这些重要特征进行可视化,这是搞明白机器是如何进行思考的重要一步。